Google ha decidido que no buscará extender su contrato el próximo año con el Departamento de Defensa sobre el tema de inteligencia artificial utilizado para analizar videos capturados por drones. De esta manera echará abajo una alianza controvertida que había hecho sonar las alarmas sobre los vínculos tecnológicos entre Silicon Valley y el Ejército estadounidense.

El gigante de la tecnología dejará de colaborar en el proyecto conocido como Project Maven cuando expire su contrato vigente por 18 meses, y que vencerá el próximo marzo, dijo una persona familiarizada con la cultura laboral de Google al periódico The Washington Post.

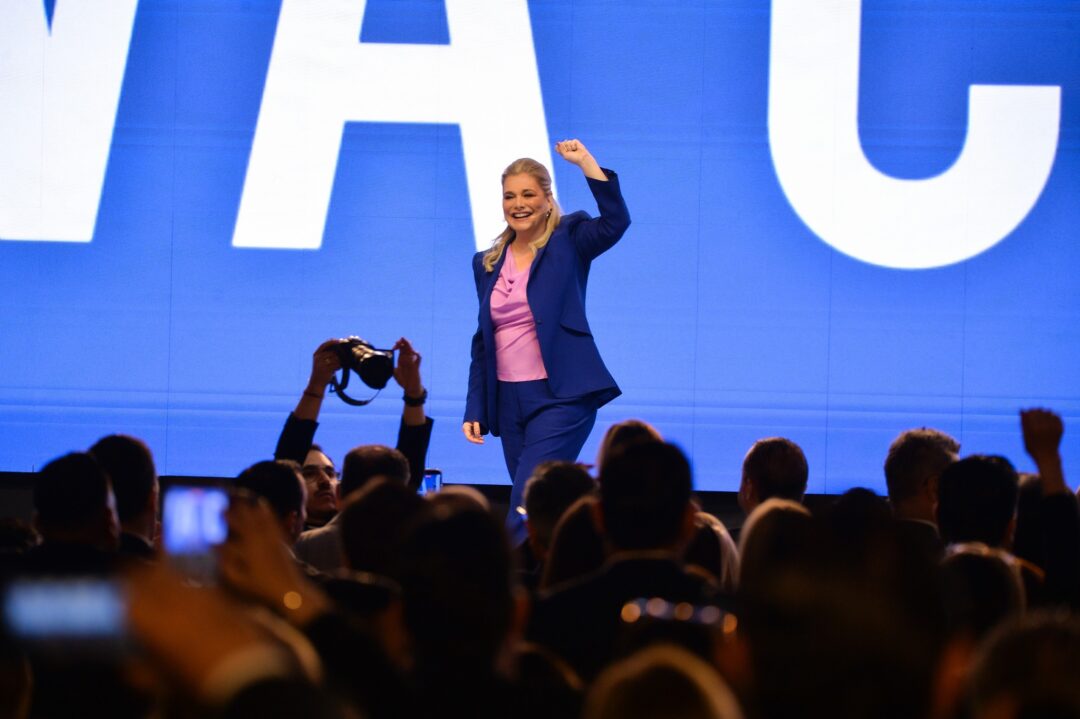

Diane Greene, quien forma parte del consejo ejecutivo de Google, reveló la decisión de la empresa a sus empleados durante una reunión el pasado viernes.

Google, que no quiso hacer ningún comentario adicional al respecto, se ha enfrentado a una reacción pública generalizada y a renuncias de empleados por ayudar a desarrollar herramientas tecnológicas que podrían ser utilizadas durante combates de guerras.

Greene comentó que Google pronto lanzará un documento sobre principios éticos de la empresa en materia de inteligencia artificial.

La decisión de Google representa un serio revés para el Pentágono en su intento de potenciar sus capacidades militares con una inteligencia artificial poderosa que podría ayudar a procesar datos del campo de batalla o identificar objetivos militares. Audricia M. Harris, una vocera del Pentágono, dijo en un comunicado: “Valoramos todas nuestras relaciones con instituciones académicas y empresas involucradas con Project Maven (…) Asociarse con las mejores universidades y empresas del mundo ayudará a preservar el liderazgo de los Estados Unidos en inteligencia artificial”.

El Proyecto Maven se lanzó en abril del 2017 con la idea de que los militares puedan usar inteligencia artificial para actualizar sus capacidades de seguridad y defensa nacional “sobre adversarios y competidores cada vez más capaces”, de acuerdo con un memorándum del Departamento de Defensa.

En un esfuerzo piloto, la inteligencia artificial se desplegó durante horas para analizar el metraje de los aviones no tripulados Predator y de otras aeronaves no tripuladas, identificando edificios y vehículos y procesando videos que posteriormente fueron analizados por humanos.

“No seas malo”

La solicitud de colaboración al sector privado, como por ejemplo a Google, que desarrolla algunos de los programas de reconocimiento de imágenes más sofisticados del mundo y emplea a algunas de las mejores mentes de la inteligencia artificial, desató rápidamente una tormenta sobre el potencial del uso de la tecnología para ayudar a matar.

Miles de empleados de Google le escribieron una carta abierta al presidente ejecutivo Sundar Pichai pidiendo a la compañía que cancele el contrato, y muchos otros firmaron una petición diciendo que la asistencia de la compañía en el desarrollo de tecnología para ser usada en zona de combate contrarresta directamente el famoso lema “No seas malo” que utiliza la propia compañía.

Bob Work, el ex subsecretario de Defensa que lanzó Project Maven el año pasado, calificó la decisión de Google como “preocupante”, ya que podría desalentar a otras empresas de Silicon Valley a trabajar con las Fuerzas Armadas en tecnologías autónomas que podrían ayudar a combatir conflictos con naciones extranjeras o, inclusive, a preservar la seguridad nacional.

La otra cara de la moneda

La decisión “parece motivada por la suposición de que cualquier uso de inteligencia artificial para apoyar al Pentágono es algo malo. ¿Pero qué hay del uso de inteligencia artificial para impulsar robots que desactivan bombas o artefactos explosivos improvisados o para evitar ataques cibernéticos en nuestra red eléctrica?”, dijo Work, miembro del Center for a New American Security, un think tank de Washington. “Todo esto salvaría la vida de nuestra gente o protegería nuestras redes o nuestra sociedad. Eso parece algo de lo que los empleados de Google podrían sentirse orgullosos”.

“No poder aprovechar el inmenso talento de Google para ayudar al Departamento de Defensa a emplear inteligencia artificial de una manera ética y moral es muy triste para nuestra sociedad y país”, agregó. “Hará más difícil competir con países que no tienen gobernantes éticos o morales sobre la inteligencia artificial particularmente en el tema de seguridad nacional”.

Anteriormente, Google ya había emitido una respuesta sobre el tema al decir que su participación en Project Maven se limitaba al uso “no ofensivo” de un software de código abierto “destinado a salvar vidas y a evitar a la gente de desarrollar un trabajo sumamente tedioso”.

Varios empleados del área de inteligencia artificial de Google revelaron a The Washington Post su creencia de que ejercen una poderosa influencia sobre la toma de decisiones de la compañía. Algunos de los principales investigadores y desarrolladores de la tecnología organizaron campañas de resistencia o amenazaron con renunciar.

El sorpresivo anuncio del pasado viernes sobre la no renovación del contrato fue bien recibido por varios empleados de elevado perfil. Meredith Whittaker, investigadora de inteligencia artificial y fundadora del grupo Open Research de Google, tuiteó el viernes: “Estoy muy contenta con esta decisión y tengo un profundo respeto por la gran cantidad de personas que trabajaron y se arriesgaron para que esto sucediera. Google no debería estar en el negocio de la guerra”.

La decisión de Google quizá no logre frenar los objetivos del Pentágono en materia de inteligencia artificial. El contrato de Google representa sólo una pequeña parte de las ambiciones técnicas de Project Maven, y otras compañías trabajan en un software similar de reconocimiento de imágenes.

El “impulso para desarrollar inteligencia artificial está mejorando dentro del Departamento de Defensa”, dijo Work. “No creo que haya ninguna manera de que se pueda prohibir su uso en aplicaciones militares, y los chinos tienen la intención de usarla para tratar de alcanzar el liderazgo tecnológico sobre los Estados Unidos”.

Los fondos para el Proyecto Maven, que también se conoce como el Equipo Transfuncional de Guerra Algorítmica, crecieron a 131 millones de dólares en el presupuesto federal firmado en marzo por el presidente Trump.

El dilema ético está sobre la mesa. Google ya eligió. Quizá por presión social, pero lo hizo.

El Financiero

Capitalhace 2 días

Capitalhace 2 días

Revistahace 2 días

Revistahace 2 días

Chihuahuahace 2 días

Chihuahuahace 2 días

Juárezhace 2 días

Juárezhace 2 días